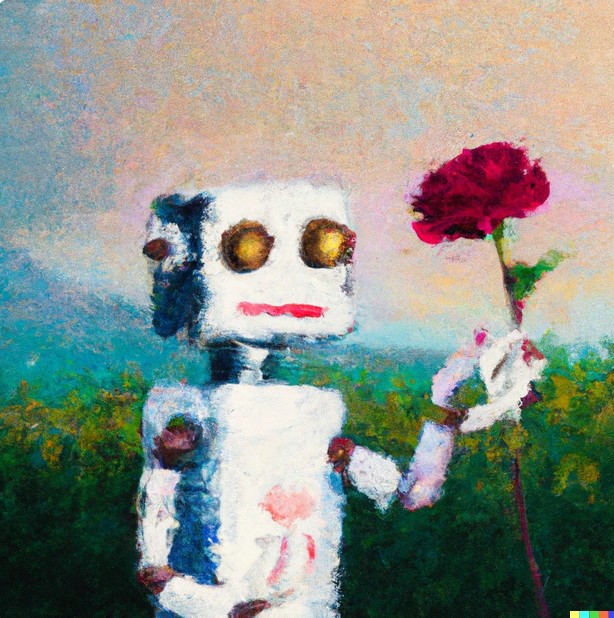

Künstliche Intelligenz (KI) und Maschinelles Lernen (ML) haben im Zuge der fortschreitenden Digitalisierung Einzug in ganz verschiedene Bereiche unserer Lebenswelt gehalten, woraus verschiedene ethische Probleme entstehen.Wir finden KI etwa in Computerspielen, in der Medizindiagnostik, der Text- und Spracherkennung, aber auch der Kunst, etwa durch DALL-E (https://openai.com/dall-e-2). Geben wir in dieses Programm die Aufforderung „Paint an impressionist oil painting showing a robot with a red flower in his hand“ ein, so erzeugt es etwa folgendes Bild:

Erstellt über Dall E 2 von Dr. Jörg Noller

Können wir KI oder ML daher als kreatives, oder gar moralisch zurechenbares Subjekt ansehen? Kann KI handeln, und ist KI sogar autonom und frei? Um diese Fragen zu beantworten, lohnt sich ein Blick zurück in die Geschichte von KI.

Der englische Informatiker Alan Turing hat in seinem 1950 erschienenen Aufsatz „Computing Machinery and Intelligence“ versucht, die Frage, ob Maschinen denken können, durch ein Spiel-Experiment ersetzt, was er „Imitation Game“ nennt. Wir können dann Maschinen intelligent nennen, wenn sie uns über ihre Identität täuschen können, d.h. wenn sie erfolgreich den Anschein erwecken, dass sie z.B. eine Frau oder ein Mann seien. Freilich wird damit die Frage nach der Intelligenz von Maschinen nur verschoben auf die Wirkung, die sie auf uns haben.

Dagegen hat der US-amerikanische Philosoph John Searle (*1932) versucht, den Grund dafür herauszufinden, warum Computer nicht denken können. Seiner Auffassung nach können Computer nur Regeln folgen, die ihnen vorgegeben sind, und sie können Zeichen entsprechend bearbeiten. Sie können sich selbst aber keine eigenen Regeln geben. Computer beherrschen Syntax, d.h. logische Regeln und deren Anwendung, aber keine Semantik, d.h. Verständnis für die Bedeutung von Zeichenfolgen. Computer können deswegen menschliche Intelligenzleistungen nur simulieren, jedoch nicht duplizieren oder realisieren.

Während John Searle sich bei seiner Kritik von KI vor allem auf symbolisch, d.h. regelfolgende KI konzentriert hatte, wirft der US-amerikanische Philosoph Hubert Dreyfus (1929-2017) einen Blick auf das Phänomen künstlicher neuronaler Netze (KNNs), die in der Gegenwart, etwa bei DALL E2, besondere Bedeutung erlangt haben. Im Gegensatz zu symbolverarbeitender KI setzen KNNs nicht bei Regeln an, sondern bei einer großen Datenbasis, aus der sich gewissermaßen empirisch Regeln bzw. Muster durch Abstraktion herausarbeiten. Obwohl KNNs dem organischen menschlichen Gehirn nachgebildet sind, besitzen sie eine prinzipielle Grenze, die Dreyfus in ihrer fehlenden Körperlichkeit verortet. Da sie keine Lebewesen sind, besitzen sie keine eigenen Interessen und Ziele. Sie können deswegen niemals autonom sein.

Das Problem der Autonomie von künstlichen Systemen ist freilich älter als die neueren Entwicklungen der Computertechnik. Bereits in Mary Shelleys (1797-1851) Roman „Frankenstein“ geht es darum, dass ein künstliches Wesen erschaffen wird, welches sich am Ende gegen seinen Erfinder wendet. Das Wort „Roboter“ stammt vom tschechischen Wort „robota“ ab, was so viel bedeutet wie „Sklavenarbeit“ und „Frondienst“. Im Jahr 1920 hat der tschechische Schriftsteller Karel Čapek ein Drama mit dem Titel „R.U.R. – Rossum’s Universal Robots“ verfasst. Darin geht es um die dystopische Erzählung eines Unternehmens, das die Produktion von künstlichen Menschen zu Ziel hat, die als Sklaven ausgenutzt werden, aber schließlich die Menschheit vernichten.

Diese Problematik zeigt sich angesichts der neueren Entwicklungen in der Kriegstechnologie. Während bei „Robotized Military Systems“ (RMS) immer Menschen in den Entscheidungsprozess (unmittelbar) involviert sind, sind bei „Lethal Autonomous Weapons Systems“ (LAWS) keine Menschen mehr in den Entscheidungsprozess (unmittelbar) involviert. Hier stellt sich nun die Frage, ob es inhärent falsch ist, wenn LAWS Menschen töten, weil sie dadurch instrumentalisiert und zu bloßen Objekten degradiert werden. Ändert sich der moralische Status einer Handlung, wenn Menschen mit RMS oder LAWS getötet werden?

Das Zusatzprotokoll zu den Genfer Abkommen vom 12. August 1949 über den Schutz der Opfer internationaler bewaffneter Konflikte, Art. 36 „Neue Waffen“, lautet deswegen folgendermaßen: Jede Hohe Vertragspartei ist verpflichtet, bei der Prüfung, Entwicklung, Beschaffung oder Einführung neuer Waffen oder neuer Mittel oder Methoden der Kriegführung festzustellen, ob ihre Verwendung stets oder unter bestimmten Umständen durch dieses Protokoll oder durch eine andere auf die Hohe Vertragspartei anwendbare Regel des Völkerrechts verboten wäre.“